背景

采用神经网络进行天气预报,我们从2014年便开始尝试,不同于传统的基于物理模型的模式推演,神经网络更多的是基于数据冲刷的自主模型学习和预测。从最开始的普通CNN(卷积神经网络)、RNN(递归神经网络)、LSTM(长短时记忆网络),到现在更复杂的Resnet(残差网络)等,都是在于释放GPU的计算潜力。因此,神经网络的预报主要应用在有大量连续规整数据的短临天气领域。

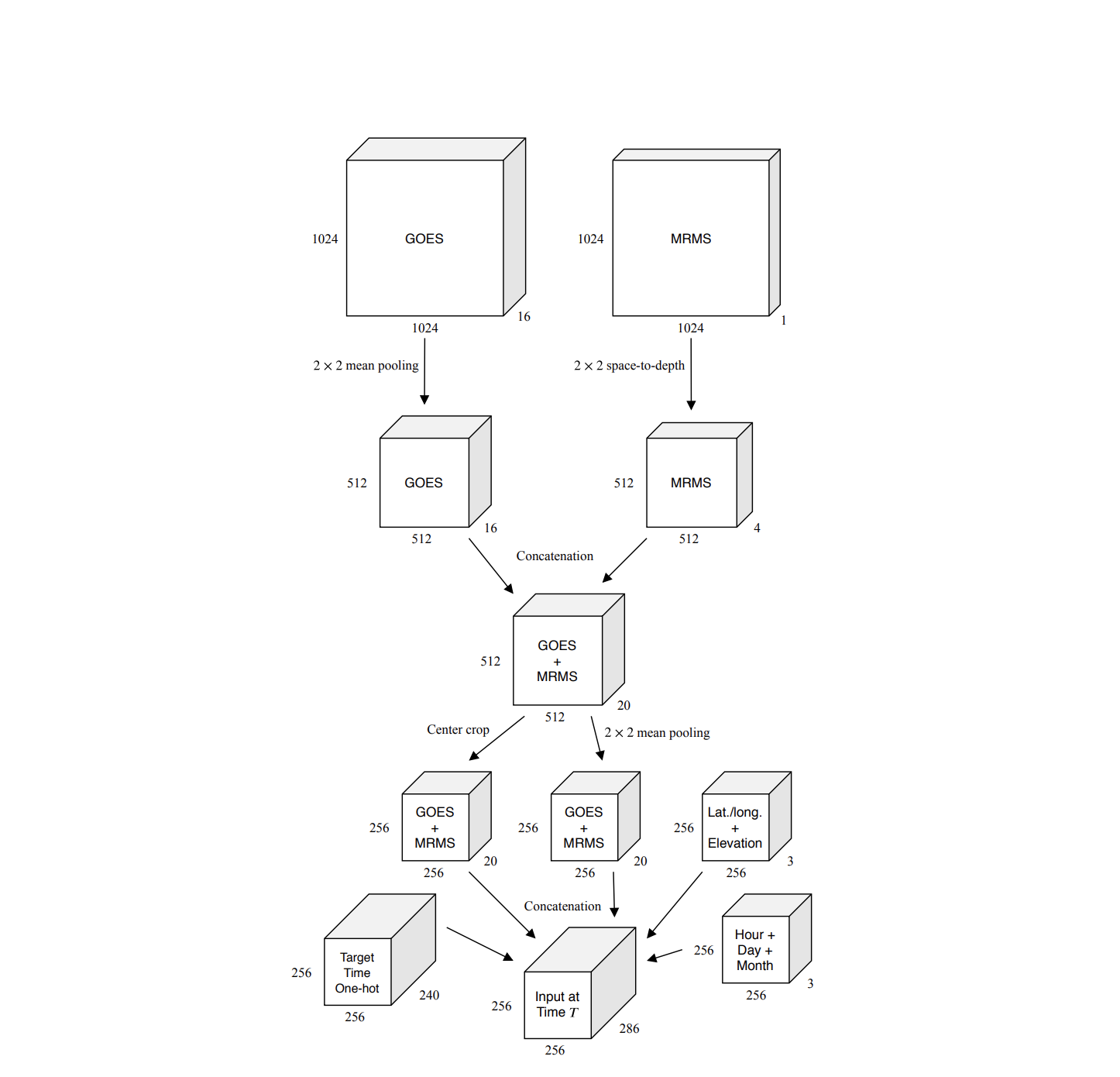

谷歌的MetNet也是这一领域的应用,大量采用了降雨雷达数据、卫星云图数据。该网络的两个核心优点在于,一是使更大的计算量运算得以实施应用(1024 * 1024 * 16);二是让预报的时间空间精度和长度都得到显著提升。

主要任务

MetNet能够预测未来8小时内的降水量,时间精度为2分钟,空间精度为1千米,覆盖面积为a 7000 × 2500 平方公里。

在任务构建时,关注区域为整个美国。 数据输入为:

- GEOS(地球静止业务环境卫星)

- MRMS(NOAA 多雷达/多传感器系统)

模型输出: 降雨量图像

模型实现

模型以每 64km*64km 执行一次,覆盖整个美国,分辨率为 1 km。然而,与这些输出区域相比,输入数据的实际物理覆盖范围要大得多,因为它必须考虑到在进行预测的时间段内云和降水场的可能运动。

模型结构

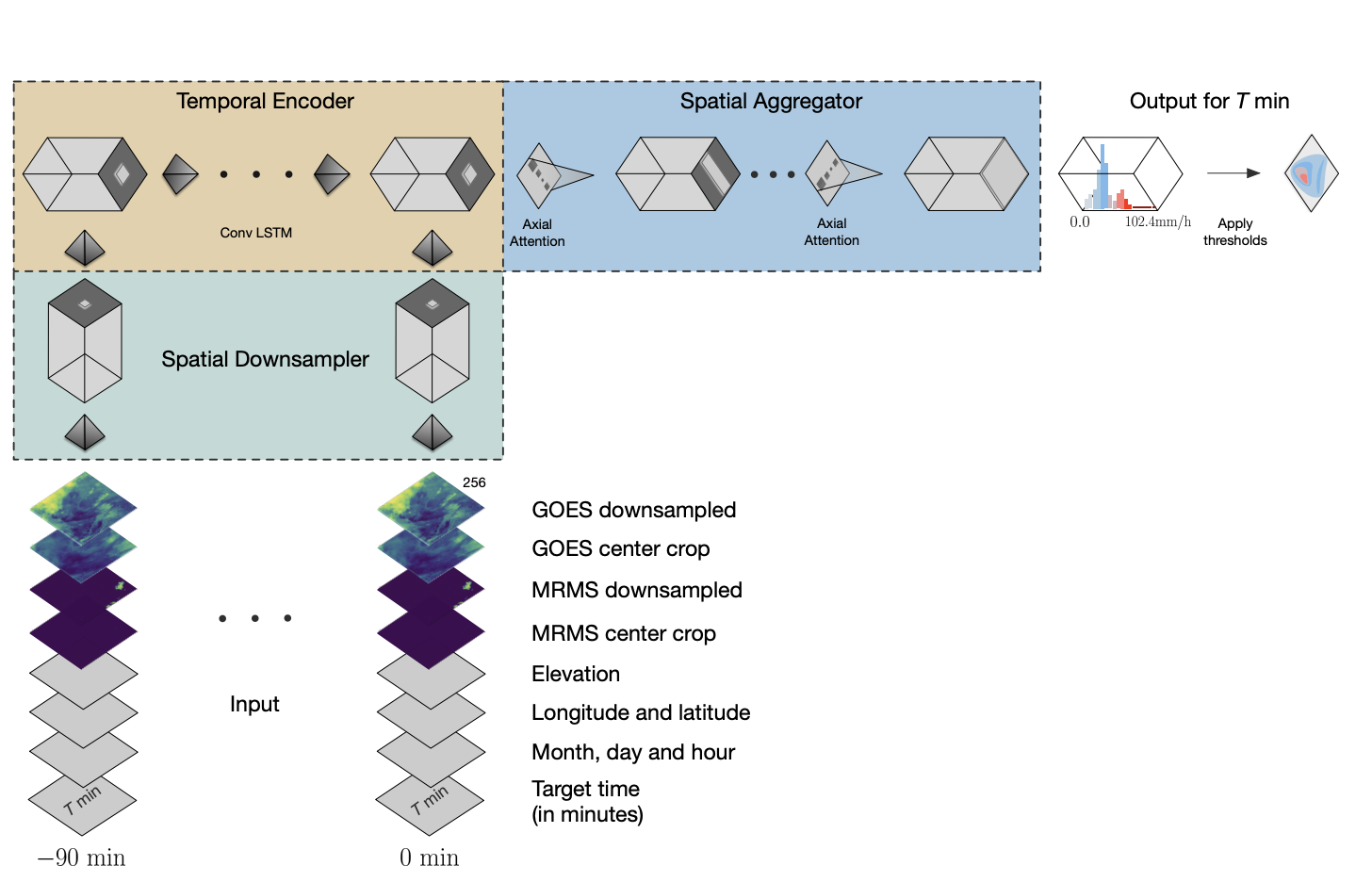

模型主要分为三部分:空间下采样器;时间编码器;空间聚集器。

模型主要分为三部分:空间下采样器;时间编码器;空间聚集器。

从图中可以看出,全分辨率处理1024*1024的数据,需要消耗大量计算和内存,且数据通道有卫星的16个通道,雷达图1个通道,因此运用了一个下采样器来减少内存和计算,同时尽可能保留有效信息。当完成下采样后,增添了天气相关的经纬度、海拔、月日时和预测目标时间等标注信息。

然后沿降采样输入数据的时间维度应用时间编码器,对 90 分钟输入数据的 7 个快照进行编码,编码片段长度为 15 分钟。时间编码器采用卷积 LSTM 实现,该卷积 LSTM 特别适合于图像序列。文中比较了输入数据长度不同情况的实验,在仅输入前两帧数据的情况下,模型输出不受影响,依然能给出高质量的降雨预报数据。这与我们之前的经验比较贴切,即预测数据仅受最近一帧数据的影响,因为降雨信息是个矢量信息,因此真实的最临近帧的信息包含在前两帧数据中。

接着,时间编码器的输出被传递到空间聚集器,空间聚集器使用轴向自关注,有效地捕获数据中的长距离空间依赖性,并基于输入目标时间使用可变数量的上下文,以在 64km*64km 的输出上进行预测。这种结构的输出是一个离散的概率分布,估计美国大陆每平方公里的给定降水率的概率。

注意到最后的输出不是降雨实际的连续的物理量,而是一个0~102.4mm/h的概率分布,x轴为0.2mm/h一个刻度,共512长度。这样做的好处是,输入一个组合的概率分布,更能贴合真是降雨预测。因为虽然直观上感觉降雨是个连续物理过程,但实际上降雨是个概率问题。

结果

研究人员根据一个降水率预测基准对 MetNet 进行评估,并将结果与两个基线进行比较:NOAA 高分辨率快速刷新 HRRR 系统,这是目前在美国运行的物理天气预测模型。

Google 的神经天气模型的一个显著优点是,它是为密集并行计算而优化的,并且非常适合在专用硬件(如 TPU)上运行。无论是针对纽约市这样的特定地点还是针对整个美国,预测可以在几秒钟内并行进行。而像 HRRR 这样的物理模型在超级计算机上的运行时间约为一小时。

在下面的图表中,研究人员量化了MetNet、HRRR 和光流基线模型之间的性能差异。这里展示了这三个模型所取得的性能,在降水率阈值为 1.0mm/h(相当于小雨)时使用 F1 分数进行评估。MetNet 神经天气模型能够在 8 小时内超过 NOAA-HRRR 系统,并且始终优于基于流量的模型。

经验

因为水汽流动,降雨的长时间预测,需要更大的空间尺度支持。即预测未来8小时的降雨量,至少需要1000km的追溯距离

降雨是个概率问题,其空间位置、有无降雨、降雨量等级都是一个概率问题。模型直接输出概率,再由概率反演物理降雨量,是一个更朴素更贴近真实世界的模型架构。同时相对于物理模型的复合预报,这种方法更适合神经网络模型,且更稳定高效。

即便用了降采样,同时用轴向注意力等方法保证有效信息不丢失。但模型计算量依然很大。需要一定的硬件支撑。